| Скачать .docx |

Реферат: Нейрокомпьютерные системы 2

Нейрокомпьютерные системы

Введение

Десять лет назад в США, а затем в Японии и странах ЕЭС были развернуты широкомасштабные национальные и международные программы исследований и разработок, направленные на создание нейрокомпьютеров - ЭВМ на основе искусственных нейронных сетей, обладающих развитым интеллектом и программируемых путем обучения на примерах решения задач. Исследования в этой области проводились еще с начала 60-х годов и считались равными по важности созданию атомной бомбы. Большинство разработок было связано с "интеллектуализацией" систем оружия и велось под покровом секретности. Да и сейчас далеко не все такие исследования носят открытый характер, хотя теперь это вызывается скорее коммерческими соображениями. Отчасти этим можно объяснить практически полное отсутствие технических подробностей в появляющихся время от времени сообщениях прессы о разработках в данной области. Однако сегодня, когда сроки завершения большинства из объявленных исследовательских программ приближаются либо уже истекли, скудость сообщений средств массовой информации, равно как и отсутствие других признаков приближения эры нейрокомпьютеров, вызывает опасение, что выполнение этих программ находится под угрозой и они готовы разделить участь небезызвестного японского проекта интеллектуальной ЭВМ 5-го поколения.

По оценкам компании Busines Communications Company Inc., в конце 1992 г. объем мирового рынка нейрокомпьютеров составлял $120 млн. (аппаратное обеспечение) и $50 млн. (программное обеспечение). Предсказывалось, что к 2000-му году он вырастет до $790 и $260 млн. соответственно. В то же время неослабевающая научная активность в этой области позволяет надеяться, что в недрах лабораторий вызревает некое "нейронное сверхоружие", способное в одночасье решить остающиеся проблемы и предложить качественно новые интеллектуальные системы, которые сменят традиционные и уже привычные ЭВМ. Некоторые новые результаты исследований украинских ученых позволяют надеяться на такой поворот событий уже в самом ближайшем будущем.

Действительно, не имея ни современного оснащения, ни сколько-нибудь приличного финансирования, находясь вдали от международных научных центров, невозможно не то что повлиять на выполнение эпохальных программ, в которых занят цвет мировой науки, но получить хотя бы мало-мальски заметный результат. Однако не стоит спешить с оценками. Экспресс мирового прогресса достаточно часто проскакивает полустанки, на которых стоило бы повернуть стрелки.

Создатели первых моделей ИНС следовали скорее интуиции, чем точному расчету. Несмотря на это, созданные системы демонстрировали поразительную способность к обучению, что было воспринято как вызов сторонниками идеи построения систем искусственного интеллекта на основе математической логики. Последние, в числе которых были такие авторитетные ученые, как М.Минский, выявив недостатки, присущие простейшей модели перцептрона, объявили эксперименты с ИНС чуть ли не шарлатанством. Это повлекло за собой спад исследований в данной области, продолжавшийся до начала 80-х годов.

Возрождению интереса к ИНС способствовал ряд обстоятельств:

· трудности с реализацией логических систем искусственного интеллекта, создаваемых в рамках японского проекта ЭВМ 5-го поколения;

· появление принципиально новых идей в отношении организации памяти и обучения нейросетей;

· заметное отставание темпов роста производительности ЭВМ от стремительного увеличения потребности в высокопроизводительных вычислениях.

Последнее стимулировало интенсификацию исследований в области параллельных вычислений и многопроцессорных систем. ИНС как естественные высокопараллельные системы, способные решать сложные неформализованные задачи, снова оказались в центре внимания ученых. Ключевую роль при этом сыграла работа Д.Хопфилда, сулившая радикальное решение проблемы обучения, бывшей камнем преткновения для перцептрона. Результаты исследований. В период 1983-86 гг. работы в области ИНС принимают характер настоящего бума. В США, Японии и странах ЕЭС разворачиваются крупные государственные программы исследований, ставящие целью создание к 1995 г. опытных образцов и освоение до 2000 г. массового производства нейрокомпьютеров - ЭВМ нового поколения на основе ИНС. Вот наиболее известные из этих программ:

· США - программа DARPA - Управления перспективного планирования НИР военного применения - 1987-1995 гг. - 400 млн. долл.;

· Япония - программа Human Frontier - 1988-1996 гг. - 1 триллион иен (6,6 млрд. долл.);

· ЕЭС - программа BRAIN (Basic Research on Adaptive Inteligence - Базовые исследования адаптивного интеллекта) - 1988-1996 гг. - 1,2 млн. долл. ежегодно.

Уже в 1987 г. в США состоялись две международные конференции по нейронным сетям, на одной из которых было представлено около 400, а на второй - более 150 докладов. Проведение таких международных форумов по ИНС становится регулярным, а их число вскоре достигает нескольких десятков в год. На наиболее представительной из последних конференций, ICNN-96 (США), было представлено более 500 докладов [5]. В Европе только за сентябрь 1997 г. на конференциях EUFIT-97 (Германия) и ICIAP (Италия) прочитано около сотни докладов по ИНС.

Атмосферу нейрокомпьютерного бума, охватившую мир в конце 80-х, характеризует высказывание президента США Буша, который в связи с бурным развитием ИНС назвал 90-е годы "десятилетием мозга". Государственная поддержка и обильное финансирование разработок привело к быстрому формированию целой исследовательской индустрии, созданию и организации массовогопроизводства необходимого аппаратного и программного оснащения: нейрокомпьютеров и нейроакселераторов для ПЭВМ, нейрочипов и нейропрограмм, учебных курсов на CD-ROM и т.п. Ужек 1992 г. только в США более 150 компаний специализировалось на выпуске различной нейропродукции, раскупаемой университетами и лабораториями, занятыми выполнением исследовательских программ.

По оценкам компании Busines Communications Company Inc., в конце 1992г. объем мирового рынка нейрокомпьютеров составлял $120 млн. (аппаратное обеспечение) и $50 млн. (программноеобеспечение). Предсказывалось, что к 2000-му году он вырастет до $790 и $260 млн. соответственно. Тревожный симптом В опубликованных недавно обзорных работах [6,7] даны многочисленные примеры практического применения нейрокомпьютеров и нейротехнологий в системах оборонного и гражданского назначения. Из них складывается картина массированного наступления нейротехнологий во всех сферах человеческой деятельности.

Следует, однако, учесть, что все эти примеры относятся к началу 90-х годов - пику нейрокомпьютерного бума, когда в данную отрасль были вовлечены многие тысячи квалифицированных специалистов и в ней образовался мощный научно-технический потенциал. Именно тогда были отработаны ключевые идеи, налажено производство средств моделирования ИНС, а также созданы образцы нейрочипов и нейрокомпьютеров, которые в свою очередь позволяют создавать крупные системы, содержащие десятки тысяч нейронов и выполняющие миллиарды вычислений в секунду.

Анализируя последующие работы, в частности содержание докладов на последних международных конференциях (ICNN-96, EUFIT-97), можно увидеть, что большая часть созданного потенциала так и осталась невостребованной. Современные исследователи отдают предпочтение относительно простым прикладным задачам, решение которых можно достичь с помощью сети из нескольких десятков нейронов. Такое предпочтение отчасти можно объяснить ростом доступности инструментальных средств на основе нейропарадигмы BP или ее аналогов, не позволяющих эффективно моделировать крупные системы.

Однако для большинства перспективных приложений (например, систем искусственного зрения и слуха) необходима обработка больших объемов информации, немыслимая без использования крупных нейрокомпьютеров. Поэтому наблюдаемая переориентация исследований на решение относительно простых задач при наличии далеко продвинутых разработок больших нейросетей представляется тревожным симптомом.

Переориентация исследований на решение относительно простых задач при наличии далеко продвинутых разработок больших нейросетей является тревожным симптомом. По мере выполнения исследовательских программ становится все более очевидным, что сложность задачи создания принципиально новых компьютеров на основе нейронных сетей была недооценена, а прогнозы стремительного роста объема рынка нейропродукции, сделанные в периодострого дефицита в экспериментальном оборудовании, далеки от реальности. Это, по-видимому, хорошо понимают ведущие производители, воздерживающиеся от больших капиталовложенийв производство нейропродукции в ожидании завершения исследовательских программ, финансируемых правительствами.

Является ли сказанное выше симптомами надвигающегося кризиса? Не постигнет ли нейрокомпьютеры судьба небезызвестного японского проекта ЭВМ 5-го поколения, бесславно канувшего в Лету в середине 80-х годов? Или в недрах многочисленных научных лабораторий зреет радикальное решение, способное повернуть вспять развитие событий? Ведь подобное уже было 15 лет назад, когда новая идея, выдвинутая Д.Хопфилдом, стала катализатором начала нейрокомпьютерного бума.

Тема 1. Принципы организации и функционирования искусственных нейронных сетей.

1. Краткий исторический обзор

Исследования в области ИНС пережили три периода активизации. Первый пик в 40-х годах обусловлен пионерской работой МакКаллока и Питтса. Второй возник в 60-х благодаря теореме сходимости перцептрона Розенблатта и работе Минского и Пейперта, указавшей ограниченные возможности простейшего перцептрона. Результаты Минского и Пейперта погасили энтузиазм большинства исследователей, особенно тех, кто работал в области вычислительных наук. Возникшее в исследованиях по нейронным сетям затишье продлилось почти 20 лет. С начала 80-х годов ИНС вновь привлекли интерес исследователей, что связано с энергетическим подходом Хопфилда и алгоритмом обратного распространения для обучения многослойного перцептрона (многослойные сети прямого распространения), впервые предложенного Вербосом и независимо разработанного рядом других авторов. Алгоритм получил известность благодаря Румельхарту в 1986году Андерсон и Розенфельд подготовили подробную историческую справку о развитии ИНС.

2.Основные нейрофизиологические данные о биологических нейронных сетях.

Hейрокомпьютерные технологии, реализующие "думающие машины", как их иногда называют, из-за способности анализировать возникающие новые ситуации и учиться на ошибках, причем не только на своих, как это обычно свойственно человеку. Несмотря на то что отечественная пресса уделяет не так много внимания нейрокомпьютерным технологиям, актуальность этой темы становится все более очевидной: многие финансовые институты по всему миру взяли на вооружение нейрокомпьютерные методы, множатся примеры использования нейросистем вместе с хранилищами данных и СУБД, применяющими нейросети в системах OLAP. В медицине и энергетике также всерьез рассматриваются возможности этой технологии.

Интеллектуальные системы на основе искусственных нейронных сетей (ИНС) позволяют с успехом решать проблемы распознавания образов, выполнения прогнозов, оптимизации, ассоциативной памяти и управления. Известны и иные, более традиционные подходы к решению этих проблем, однако они не обладают необходимой гибкостью за пределами ограниченных условий. ИНС дают многообещающие альтернативные решения, и многие приложения выигрывают от их использования.

Длительный период эволюции придал мозгу человека много качеств, которые отсутствуют как в машинах с архитектурой фон Неймана, так и в современных параллельных компьютерах. К ним относятся:

• массовый параллелизм,

• распределенное представление информации и вычисления,

• способность к обучению и способность к обобщению,

• адаптивность,

• свойство контекстуальной обработки информации,

• толерантность к ошибкам,

• низкое энергопотребление.

Можно предположить, что приборы, построенные на тех же принципах, что и биологические нейроны, будут обладать перечисленными характеристиками.

3.Биологические нейронные сети

Нейрон (нервная клетка) является особой биологической клеткой, которая обрабатывает информацию (рис. 1). Она состоит из тела клетки (cell body), или сомы (soma), и двух типов внешних древоподобных ветвей: аксона (axon) и дендритов (dendrites). Тело клетки включает ядро (nucleus), которое содержит информацию о наследственных свойствах, и плазму, обладающую молекулярными средствами для производства необходимых нейрону материалов. Нейрон получает сигналы (импульсы) от других нейронов через дендриты (приемники) и передает сигналы, сгенерированные телом клетки, вдоль аксона (передатчик), который в конце разветвляется на волокна (strands). На окончаниях этих волокон находятся синапсы

|

(synapses).

Рисунок 1.

Схема биологического нейрона.

Синапс является элементарной структурой и функциональным узлом между двумя нейронами (волокно аксона одного нейрона и дендрит другого). Когда импульс достигает синаптического окончания, высвобождаются определенные химические вещества, называемые нейротрансмиттерами. Нейротрансмиттеры диффундируют через синаптическую щель, возбуждая или затормаживая, в зависимости от типа синапса, способность нейрона-приемника генерировать электрические импульсы. Результативность синапса может настраиваться проходящими через него сигналами, так что синапсы могут обучаться в зависимости от активности процессов, в которых они участвуют. Эта зависимость от предыстории действует как память, которая, возможно, ответственна за память человека.

Кора головного мозга человека является протяженной, образованной нейронами поверхностью толщиной от 2 до 3 мм с площадью около 2200 см2, что вдвое превышает площадь поверхности стандартной клавиатуры. Кора головного мозга содержит около 1011 нейронов, что приблизительно равно числу звезд Млечного пути. Каждый нейрон связан с 103 - 104 другими нейронами. В целом мозг человека содержит приблизительно от 1014 до 1015 взаимосвязей.

Нейроны взаимодействуют посредством короткой серии импульсов, как правило, продолжительностью несколько мсек. Сообщение передается посредством частотно-импульсной модуляции. Частота может изменяться от нескольких единиц до сотен герц, что в миллион раз медленнее, чем самые быстродействующие переключательные электронные схемы. Тем не менее сложные решения по восприятию информации, как, например, распознавание лица, человек принимает за несколько сотен мс. Эти решения контролируются сетью нейронов, которые имеют скорость выполнения операций всего несколько мс. Это означает, что вычисления требуют не более 100 последовательных стадий. Другими словами, для таких сложных задач мозг "запускает" параллельные программы, содержащие около 100 шагов. Это известно как правило ста шагов. Рассуждая аналогичным образом, можно обнаружить, что количество информации, посылаемое от одного нейрона другому, должно быть очень маленьким (несколько бит). Отсюда следует, что основная информация не передается непосредственно, а захватывается и распределяется в связях между нейронами. Этим объясняется такое название, как коннекционистская модель, применяемое к ИНС.

4. От биологических сетей к ИНС

Современные цифровые вычислительные машины превосходят человека по способности производить числовые и символьные вычисления. Однако человек может без усилий решать сложные задачи восприятия внешних данных (например, узнавание человека в толпе только по его промелькнувшему лицу) с такой скоростью и точностью, что мощнейший в мире компьютер по сравнению с ним кажется безнадежным тугодумом. В чем причина столь значительного различия в их производительности? Архитектура биологической нейронной системы совершенно не похожа на архитектуру машины фон Неймана (Таблица 1), существенно влияет на типы функций, которые более эффективно исполняются каждой моделью.

Таблица 1.

Машина фон Неймана по сравнению с биологической нейронной системой.

Машина фон Неймана |

Биологическая нейронная система |

|

Процессор |

Сложный Высокоскоростной Один или несколько |

Простой Низкоскоростной Большое количество |

Память |

Отделена от процессора Локализована Адресация не по содержанию |

Интегрирована в процессор Распределенная Адресация по содержанию |

| Надежность | Высокая уязвимость | Живучесть |

Специализация |

Численные и символьные oперации |

Проблемы восприятия |

| Среда функционирования | Строго определенная Строго ограниченная |

Плохо определенная Без ограничений |

Подобно биологической нейронной системе ИНС является вычислительной системой с огромным числом параллельно функционирующих простых процессоров с множеством связей. Модели ИНС в некоторой степени воспроизводят "организационные" принципы, свойственные мозгу человека. Моделирование биологической нейронной системы с использованием ИНС может также способствовать лучшему пониманию биологических функций. Такие технологии производства, как VLSI (сверхвысокий уровень интеграции) и оптические аппаратные средства, делают возможным подобное моделирование.

Глубокое изучение ИНС требует знания нейрофизиологии, науки о познании, психологии, физики (статистической механики), теории управления, теории вычислений, проблем искусственного интеллекта, статистики/математики, распознавания образов, компьютерного зрения, параллельных вычислений и аппаратных средств (цифровых/аналоговых/VLSI/оптических). С другой стороны, ИНС также стимулируют эти дисциплины, обеспечивая их новыми инструментами и представлениями. Этот симбиоз жизненно необходим для исследований по нейронным сетям.

5. Модель технического нейрона

МакКаллок и Питтс предложили использовать бинарный пороговый элемент в качестве модели искусственного нейрона. Этот математический нейрон вычисляет взвешенную сумму n входных сигналов xj, j = 1, 2... n, и формирует на выходе сигнал величины 1, если эта сумма превышает определенный порог u, и 0 - в противном случае.

Часто удобно рассматривать u как весовой коэффициент, связанный с постоянным входом x0 = 1. Положительные веса соответствуют возбуждающим связям, а отрицательные - тормозным. МакКаллок и Питтс доказали, что при соответствующим образом подобранных весах совокупность параллельно функционирующих нейронов подобного типа способна выполнять универсальные вычисления. Здесь наблюдается определенная аналогия с биологическим нейроном: передачу сигнала и взаимосвязи имитируют аксоны и дендриты, веса связей соответствуют синапсам, а пороговая функция отражает активность сомы.

В основу искусственных нейронных сетей положены следующие черты живых нейронных сетей, позволяющие им хорошо справляться с нерегулярными задачами:

- простой обрабатывающий элемент - нейрон;

- очень большое число нейронов участвует в обработке информации;

- один нейрон связан с большим числом других нейронов

(глобальные связи);

- изменяющиеся по весу связи между нейронами;

- массированная параллельность обработки информации.

Прототипом для создания нейрона послужил биологический нейрон головного мозга. Биологический нейрон имеет тело, совокупность отростков - дендридов, по которым в нейрон поступают входные сигналы, и отросток - аксон, передающий выходной сигнал нейрона другим клеткам. Точка соединения дендрида и аксона называется синапсом. Упрощенно функционирование нейрона можно представить следующим образом:

1) нейрон получает от дендридов набор (вектор) входных сигналов;

2) в теле нейрона оценивается суммарное значение входных сигналов. Однако входы нейрона неравнозначны. Каждый вход характеризуется некоторым весовым коэффициентом, определяющим важность поступающей по нему информации. Таким образом, нейрон не просто суммирует значения входных сигналов, а вычисляет скалярное произведение вектора входных сигналов и вектора весовых коэффициентов;

3) нейрон формирует выходной сигнал, интенсивность которого

зависит от значения вычисленного скалярного произведения. Если оно не превышает некоторого заданного порога, то выходной сигнал не формируется вовсе - нейрон "не срабатывает";

4) выходной сигнал поступает на аксон и передается дендридам

других нейронов.

Поведение искусственной нейронной сети зависит как от значения весовых параметров, так и от функции возбуждения нейронов.

Известны три основных вида функции возбуждения:

- пороговая,

- линейная

- сигмоидальная.

Для пороговых элементов выход устанавливается на одном из двух уровней в зависимости от того, больше или меньше суммарный сигнал на входе нейрона некоторого порогового значения. Для линейных элементов выходная активность пропорциональна суммарному взвешенному входу нейрона.

Для сигмоидальных элементов в зависимости от входного сигнала, выход варьируется непрерывно, но не линейно, по мере изменения входа. Сигмоидальные элементы имеют больше сходства с реальными нейронами, чем линейные или пороговые, но любой из этих типов можно рассматривать лишь как приближение.

Нейронная сеть представляет собой совокупность большого числа сравнительно простых элементов - нейронов, топология соединений которых зависит от типа сети. Чтобы создать нейронную сеть для решения какой-либо конкретной задачи, мы должны выбрать, каким образом следует соединять нейроны друг с другом, и соответствующим образом подобрать значения весовых параметров на этих связях. Может ли влиять один элемент на другой, зависит от установленных соединений. Вес соединения определяет силу влияния.

6.Архитектура нейронной сети

ИНС может рассматриваться как направленный граф со взвешенными связями, в котором искусственные нейроны являются узлами. По архитектуре связей ИНС могут быть сгруппированы в два класса (рис. 2): сети прямого распространения, в которых графы не имеют петель, и рекуррентные сети, или сети с обратными связями.

Рисунок 2.Систематизация архитектур сетей прямого распространения и рекуррентных (с обратной связью).

В наиболее распространенном семействе сетей первого класса, называемых многослойным перцептроном, нейроны расположены слоями и имеют однонаправленные связи между слоями. На рис. 2 представлены типовые сети каждого класса. Сети прямого распространения являются статическими в том смысле, что на заданный вход они вырабатывают одну совокупность выходных значений, не зависящих от предыдущего состояния сети. Рекуррентные сети являются динамическими, так как в силу обратных связей в них модифицируются входы нейронов, что приводит к изменению состояния сети.

Тема 2.Обучение ИНС.

Способность к обучению является фундаментальным свойством мозга. В контексте ИНС процесс обучения может рассматриваться как настройка архитектуры сети и весов связей для эффективного выполнения специальной задачи. Обычно нейронная сеть должна настроить веса связей по имеющейся обучающей выборке. Функционирование сети улучшается по мере итеративной настройки весовых коэффициентов. Свойство сети обучаться на примерах делает их более привлекательными по сравнению с системами, которые следуют определенной системе правил функционирования, сформулированной экспертами.

Для конструирования процесса обучения, прежде всего, необходимо иметь модель внешней среды, в которой функционирует нейронная сеть - знать доступную для сети информацию. Эта модель определяет парадигму обучения . Во-вторых, необходимо понять, как модифицировать весовые параметры сети - какие правила обучения управляют процессом настройки. Алгоритм обучения означает процедуру, в которой используются правила обучения для настройки весов.

Существуют три парадигмы обучения:

- "с учителем",

- "без учителя" (самообучение)

- смешанная.

В первом случае нейронная сеть располагает правильными ответами (выходами сети) на каждый входной пример. Веса настраиваются так, чтобы сеть производила ответы как можно более близкие к известным правильным ответам. Усиленный вариант обучения с учителем предполагает, что известна только критическая оценка правильности выхода нейронной сети, но не сами правильные значения выхода.

Обучение без учителя не требует знания правильных ответов на каждый пример обучающей выборки. В этом случае раскрывается внутренняя структура данных или корреляции между образцами в системе данных, что позволяет распределить образцы по категориям.

При смешанном обучении часть весов определяется посредством обучения с учителем, в то время как остальная получается с помощью самообучения.

Теория обучения рассматривает три фундаментальных свойства, связанных с обучением по примерам:

- емкость,

- сложность образцов

- вычислительная сложность.

Под емкостью понимается, сколько образцов может запомнить сеть, и какие функции и границы принятия решений могут быть на ней сформированы.

Сложность образцов определяет число обучающих примеров, необходимых для достижения способности сети к обобщению. Слишком малое число примеров может вызвать "переобученность" сети, когда она хорошо функционирует на примерах обучающей выборки, но плохо - на тестовых примерах, подчиненных тому же статистическому распределению. Известны 4 основных типа правил обучения:

- коррекция по ошибке,

- машина Больцмана,

- правило Хебба

- обучение методом соревнования.

1.Правило коррекции по ошибке .

При обучении с учителем для каждого входного примера задан желаемый выход d. Реальный выход сети y может не совпадать с желаемым. Принцип коррекции по ошибке при обучении состоит в использовании сигнала (d-y) для модификации весов, обеспечивающей постепенное уменьшение ошибки. Обучение имеет место только в случае, когда перцептрон ошибается. Известны различные модификации этого алгоритма обучения.

2.Обучение Больцмана.

Представляет собой стохастическое правило обучения, которое следует из информационных теоретических и термодинамических принципов. Целью обучения Больцмана является такая настройка весовых коэффициентов, при которой состояния видимых нейронов удовлетворяют желаемому распределению вероятностей. Обучение Больцмана может рассматриваться как специальный случай коррекции по ошибке, в котором под ошибкой понимается расхождение корреляций состояний в двух режимах .

3.Правило Хебба

Самым старым обучающим правилом является постулат обучения Хебба. Хебб опирался на следующие нейрофизиологические наблюдения: если нейроны с обеих сторон синапса активизируются одновременно и регулярно, то сила синаптической связи возрастает. Важной особенностью этого правила является то, что изменение синаптического веса зависит только от активности нейронов, которые связаны данным синапсом. Это существенно упрощает цепи обучения в реализации VLSI.

4.Обучение методом соревнования

В отличие от обучения Хебба, в котором множество выходных нейронов могут возбуждаться одновременно, при соревновательном обучении выходные нейроны соревнуются между собой за активизацию. Это явление известно как правило "победитель берет все". Подобное обучение имеет место в биологических нейронных сетях. Обучение посредством соревнования позволяет кластеризовать входные данные: подобные примеры группируются сетью в соответствии с корреляциями и представляются, одним элементом.

При обучении модифицируются только веса "победившего" нейрона. Эффект этого правила достигается за счет такого изменения сохраненного в сети образца (вектора весов связей победившего нейрона), при котором он становится чуть ближе ко входному примеру. На рис. 3 дана геометрическая иллюстрация обучения методом соревнования. Входные векторы нормализованы и представлены точками на поверхности сферы. Векторы весов для трех нейронов инициализированы случайными значениями. Их начальные и конечные значения после обучения отмечены Х на рис. 3а и 3б соответственно. Каждая из трех групп примеров обнаружена одним из выходных нейронов, чей весовой вектор настроился на центр тяжести обнаруженной группы.

Рисунок 3.

Пример обучения методом соревнования:

(а) перед обучением; (б) после обучения.

Можно заметить, что сеть никогда не перестанет обучаться, если параметр скорости обучения не равен 0. Некоторый входной образец может активизировать другой выходной нейрон на последующих итерациях в процессе обучения. Это ставит вопрос об устойчивости обучающей системы.

Система считается устойчивой, если ни один из примеров обучающей выборки не изменяет своей принадлежности к категории после конечного числа итераций обучающего процесса. Один из способов достижения стабильности состоит в постепенном уменьшении до 0 параметра скорости обучения. Однако это искусственное торможение обучения вызывает другую проблему, называемую пластичностью и связанную со способностью к адаптации к новым данным. Эти особенности обучения методом соревнования известны под названием дилеммы стабильности-пластичности Гроссберга.

В Таблице 2 представлены различные алгоритмы обучения и связанные с ними архитектуры сетей (список не является исчерпывающим). В последней колонке перечислены задачи, для которых может быть применен каждый алгоритм. Каждый алгоритм

обучения ориентирован на сеть определенной архитектуры и предназначен для ограниченного класса задач. Кроме рассмотренных, следует упомянуть некоторые другие алгоритмы: Adaline и Madaline, линейный дискриминантный анализ, проекции Саммона, анализ главных компонентов.

Таблица 2.

Известные алгоритмы обучения.

Парадигма |

Обучающее правило |

Архитектура |

Алгоритм обучения |

Задача |

С учителем |

Коррекция ошибки | Однослойный и многослойный перцептрон | Алгоритмы обучения перцептрона Обратное распространение Adaline и Madaline |

Классификация образов Аппроксимация функций Предскащание, управление |

Больцман |

Рекуррентная |

Алгоритм обучения Больцмана |

Классификация образов | |

Хебб |

Многослойная прямого распространения |

Линейный дискриминантный анализ |

Анализ данных Классификация образов |

|

Соревнование |

Соревнование |

Векторное квантование |

Категоризация внутри класса Сжатие данных |

|

| Сеть ART | ARTMap |

Классификация образов | ||

Без учителя |

Коррекция ошибки | Многослойная прямого распространения |

Проекция Саммона | Категоризация внутри класса Анализ данных |

| Хебб | Прямого распространения или соревнование |

Анализ главных компонентов | Анализ данных Сжатие данных |

|

| Сеть Хопфилда | Обучение ассоциативной памяти |

Ассоциативная память |

||

| Соревнование | Соревнование | Векторное квантование | Категоризация Сжатие данных |

|

| SOM Кохонена | SOM Кохонена | Категоризация Анализ данных |

||

| Сети ART | ART1, ART2 | Категоризация | ||

| Смешанная | Коррекция ошибки и соревнование |

Сеть RBF | Алгоритм обучения RBF | Классификация образов Аппроксимация функций Предсказание, управление |

5. Самоорганизующиеся карты Кохонена

Самоорганизующиеся карты Кохонена (SOM) обладают благоприятным свойством сохранения топологии, которое воспроизводит важный аспект карт признаков в коре головного мозга высокоорганизованных животных. В отображении с сохранением топологии близкие входные примеры возбуждают близкие выходные элементы. На рис. 2 показана основная архитектура сети SOM Кохонена. По существу она представляет собой двумерный массив элементов, причем каждый элемент связан со всеми n входными узлами.

Такая сеть является специальным случаем сети, обучающейся методом соревнования, в которой определяется пространственная окрестность для каждого выходного элемента. Локальная окрестность может быть квадратом, прямоугольником или окружностью. Начальный размер окрестности часто устанавливается в пределах от 1/2 до 2/3 размера сети и сокращается согласно определенному закону (например, по экспоненциально убывающей зависимости). Во время обучения модифицируются все веса, связанные с победителем и его соседними элементами.

Самоорганизующиеся карты Кохонена могут быть использованы для проектирования многомерных данных, аппроксимации плотности и кластеризации. Эта сеть успешно применялась для распознавания речи, обработки изображений, в робототехнике и в задачах управления. Параметры сети включают в себя размерность массива нейронов, число нейронов в каждом измерении, форму окрестности, закон сжатия окрестности и скорость обучения.

6.Модели теории адаптивного резонанса

Напомним, что дилемма стабильности-пластичности является важной особенностью обучения методом соревнования. Как обучать новым явлениям (пластичность) и в то же время сохранить стабильность, чтобы существующие знания не были стерты или разрушены?

Карпентер и Гроссберг, разработавшие модели теории адаптивного резонанса (ART1, ART2 и ARTMAP), сделали попытку решить эту дилемму. Сеть имеет достаточное число выходных элементов, но они не используются до тех пор, пока не возникнет в этом необходимость. Будем говорить, что элемент распределен (не распределен), если он используется (не используется). Обучающий алгоритм корректирует имеющийся прототип категории, только если входной вектор в достаточной степени ему подобен. В этом случае они резонируют. Степень подобия контролируется параметром сходства k, 0<k<1, который связан также с числом категорий. Когда входной вектор недостаточно подобен ни одному существующему прототипу сети, создается новая категория, и с ней связывается нераспределенный элемент со входным вектором в качестве начального значения прототипа. Если не находится нераспределенного элемента, то новый вектор не вызывает реакции сети.

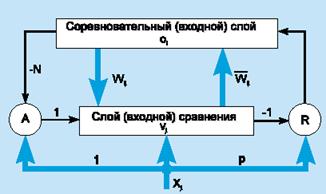

Чтобы проиллюстрировать модель, рассмотрим сеть ART1, которая рассчитана на бинарный (0/1) вход. Упрощенная схема архитектуры ART1 [2] представлена на рис. 4. Она содержит два слоя элементов с полными связями.

Рисунок 4.Сеть ART1.

Направленный сверху вниз весовой вектор wj соответствует элементу j входного слоя, а направленный снизу вверх весовой вектор i связан с выходным элементом i; i является нормализованной версией wi . Векторы wj сохраняют прототипы кластеров. Роль нормализации состоит в том, чтобы предотвратить доминирование векторов с большой длиной над векторами с малой длиной. Сигнал сброса R генерируется только тогда, когда подобие ниже заданного уровня.

Модель ART1 может создать новые категории и отбросить входные примеры, когда сеть исчерпала свою емкость. Однако число обнаруженных сетью категорий чувствительно к параметру сходства.

Тема 3. Ассоциативные ИНС.

Модель Маккалоха

Теоретические основы нейроматематики были заложены в начале 40-х годов. В 1943 году У. Маккалох и его ученик У. Питтс сформулировали основные положения теории деятельности головного мозга. Ими были получены следующие результаты:

- разработана модель нейрона как простейшего процессорного

элемента, выполняющего вычисление переходной функции от скалярного произведения вектора входных сигналов и вектора весовых коэффициентов;

- предложена конструкция сети таких элементов для выполнения

логических и арифметических операций;

- сделано основополагающее предположение о том, что такая сеть способна обучаться, распознавать образы, обобщать полученную информацию.

Несмотря на то, что за прошедшие годы нейроматематика ушла

далеко вперед, многие утверждения Макклоха остаются актуальными и поныне. В частности, при большом разнообразии моделей нейронов принцип их действия, заложенный Макклохом и Питтсом, остается неизменным.

Недостатком данной модели является сама модель нейрона -

"пороговой" вид переходной функции. В формализме У. Маккалоха и У. Питтса нейроны имеют состояния 0, 1 и пороговую логику перехода из состояния в состояние. Каждый нейрон в сети определяет взвешенную сумму состояний всех других нейронов и сравнивает ее с порогом, чтобы определить свое собственное состояние. Пороговый вид функции не предоставляет нейронной сети достаточную гибкость при обучении и настройке на заданную задачу. Если значение вычисленного скалярного произведения, даже незначительно, не достигает до заданного порога, то выходной сигнал не формируется вовсе и нейрон "не срабатывает". Это значит, что теряется интенсивность выходного сигнала (аксона) данного нейрона и, следовательно, формируется невысокое значение уровня на взвешенных входах в следующем слое нейронов.

Модель Розенблата

Серьезное развитие нейрокибернетика получила в работах американского нейрофизиолога Френсиса Розенблата (Корнелльский университет). В 1958 году он предложил свою модель нейронной сети.

Розенблат ввел в модель Маккаллока и Питтса способность связей к

модификации, что сделало ее обучаемой. Эта модель была названа

персептроном. Первоначально персептрон представлял собой однослойную структуру с жесткой пороговой функцией процессорного элемента и бинарными или многозначными входами. Первые персептроны были способны распознавать некоторые буквы латинского алфавита. Впоследствии модель персептрона была значительно усовершенствована.

Персептрон применялся для задачи автоматической классификации, которая в общем случае состоит в разделении пространства признаков между заданным количеством классов. В двухмерном случае требуется провести линию на плоскости, отделяющую одну область от другой. Персептрон способен делить пространство только прямыми линиями (плоскостями).

Алгоритм обучения персептрона выглядит следующим образом:

1) системе предъявляется эталонный образ;

2) если выходы системы срабатывают правильно, весовые коэффициенты связей не изменяются;

3) если выходы срабатывают неправильно, весовым коэффициентам дается небольшое приращение в сторону повышения качества распознавания.

Серьезным недостатком персептрона является то, что не всегда

существует такая комбинация весовых коэффициентов, при которой имеющееся множество образов будет распознаваться данным персептроном. Причина этого недостатка состоит в том, что лишь небольшое количество задач предполагает, что линия, разделяющая эталоны, будет прямой. Обычно это достаточно сложная кривая, замкнутая или разомкнутая. Если учесть, что однослойный персептрон реализует только линейную разделяющую поверхность, применение его там, где требуется нелинейная, приводит к неверному распознаванию (эта проблема называется линейной неразделимостью пространства признаков). Выходом из этого положения является использование многослойного персептрона, способного строить ломаную границу между распознаваемыми образами.

Описанная проблема не является единственной трудностью, возникающей при работе с персептронами - также слабо формализован метод обучения персептрона. Персептрон поставил ряд вопросов, работа над решением которых привела к созданию более "разумных" нейронных сетей и разработке методов, нашедших применение не только в нейрокибернетике (например, метод группового учета аргументов, применяемый для идентификации математических моделей).

Модель Хопфилда

В 70-е годы интерес к нейронным сетям значительно упал, однако работы по их исследованию продолжались. Был предложен ряд интересных разработок, таких, например, как когнитрон, способный хорошо распознавать достаточно сложные образы (иероглифы и т.п.) независимо от поворота и изменения масштаба изображения. Автором когнитрона является японский ученый И. Фукушима.

Новый виток быстрого развития моделей нейронных сетей, который начался 8-9 лет тому назад, связан с работами Амари, Андерсона, Карпентера, Кохена и других, и в особенности, Хопфилда, а также под влиянием обещающих успехов оптических технологий и зрелой фазы развития СБИС для реализации новых архитектур.

Начало современному математическому моделированию нейронных вычислений было положено работами Хопфилда в 1982 году, в которых была сформулирована математическая модель ассоциативной памяти на нейронной сети с использованием правила Хеббиана для программирования сети.

Но не столько сама модель послужила толчком к появлению работ других авторов на эту тему, сколько введенная Хопфилдом функция вычислительной энергии нейронной сети. Это аналог функции Ляпунова в динамических системах. Показано, что для однослойной нейронной сети со связями типа "все на всех" характерна сходимость к одной из конечного множества равновесных точек, которые являются локальными минимумами функции энергии, содержащей в себе всю структуру взаимосвязей в сети. Понимание такой динамики в нейронной сети было и у других исследователей. Однако, Хопфилд и Тэнк показали как конструировать функцию энергии для конкретной оптимизационной задачи и как использовать ее для отображения задачи в нейронную сеть. Этот подход получил развитие и для решения других комбинаторных оптимизационных задач. Привлекательность подхода Хопфилда состоит в том, что нейронная сеть для конкретной задачи может быть запрограммирована без обучающих итераций. Веса связей вычисляются на основании вида функции энергии, сконструированной для этой задачи.

Развитием модели Хопфилда для решения комбинаторных оптимизационных задач и задач искусственного интеллекта является машина Больцмана , предложенная и исследованная Джефери Е. Хинтоном и Р.Земелом.

В ней, как и в других моделях, нейрон имеет состояния 1, 0 и связь между нейронами обладает весом. Каждое состояние сети характеризуется определенным значением функции консенсуса (аналог функции энергии). Максимум функции консенсуса соответствует оптимальному решению задачи.

Имеется следующая информация о результатах моделирования на ЭВМ работы нейронной сети. Моделировалась асинхронная работа сети Хопфилда. Сеть работает хорошо, т.е. без ошибок восстанавливает эталонные образы из случайных, если в нее записывается не более 15 % эталонных образов. Испытания проводились для 30 нейронов и для 100 нейронов в сети. Бралось некоторое количество случайных векторов в качестве эталонных и строилась соответствующая матрица весов связей. Моделирование при 100 нейронах было существенно более медленным процессам, чем при 30 нейронах, хотя качественная картина и в том и в другом случаях была одна и та же. Приблизительно 88 % испытаний заканчивались в эталонных состояниях, 10 % - в устойчивых состояниях, близких к эталонным. При расстоянии <=5 между начальным и эталонным векторами, эталонное состояние достигалось в 90 % случаев. С увеличением расстояния, вероятность попадания в наиболее близкое эталонное состояние гладко падала.

При расстоянии 12 вероятность была равна 0.2. Устойчивые состояния, слишком близкие друг к другу, имеют тенденцию "сливаться", они попадают в одну впадину на энергетической поверхности. Программировалась задача коммивояжера на основе сети Хопфилда. Сетью из 100 нейронов для 20 различных случайных начальных состояний были определены маршруты, 16 из которых были приемлемыми, 50% попыток дали 2 пути 2.83 и 2.71 (цифры приводятся, чтобы показать как они близки) при кратчайшем 2.67. Это результаты моделирования работы сети с непрерывной моделью нейрона. Моделировалась также задача коммивояжера, но для сети типа машина Больцмана, проводилась при следующих значениях управляющих параметров: A = 0.95, L

= 10, M = 100 (A - положительное число меньше единицы, но близкое к ней, L - число испытаний, которые проводятся без изменений, M - число последовательных испытаний, не приводящих к изменению состояния машины, как критерия завершения процесса). Процесс запускался 100 раз для n = 10 всего в сети N = n^2 нейронов) и 25 раз для n = 30 при различных нормальных состояниях машины Больцмана.

Для n = 10 получился оптимальный результат, для n = 30 - решение

на 14 % хуже оптимального. Отметим, что вероятностный механизм функционирования машины Больцмана дает возможность получить на ней несколько лучшие результаты оптимизации, чем на модели Хопфилда.

Нейропарадигмы неитеративного типа являются развитием концепции сети Д.Хопфилда, основанной на сходстве полносвязной нейронной сети со спиновым стеклом - мультиустойчивой системой, которая, будучи выведена из состояния равновесия, совершает колебания, завершающиеся переходом (конвергенцией) в ближайшее устойчивое состояние (атрактор), отвечающее минимуму потенциальной энергии. Проводя аналогию между атракторами спинового стекла и следами памяти, Д.Хопфилд пришел к выводу, что конвергенция является аналогом ассоциативного поиска информации. Это позволило ему применить известные соотношения между значениями атракторов и силой внутренних связей спинового стекла для нахождения величины веса связей нейронной сети по заданным значениям векторов устойчивых состояний. Таким образом, сеть Хопфилда достигает того же результата, что и при обучении ИНС, минуя длительный итеративный процесс коррекции веса связей по правилам Хебба.

Д.Хопфилду удалось также показать, что предложенная модель ИНС обладает еще одним ценным качеством. При конвергенции она выполняет поиск глобального минимума энергетической функции. Устанавливая определенным образом весасвязей в начальное состояние, можно использовать это свойство сети для решения сложных оптимизационных задач. Благодаря параллельной работе нейронов такие задачи решаются намного быстрее, чем с помощью обычных ЭВМ.

Рис. 5 Нейронная сеть Хопфилда

Структура сети Хопфилда изображена на рис.5. Сеть однородна и симметрична. Она не содержит ни скрытых нейронов,ни выделенных рецепторов и эффекторов. Стимулы и реакции являются составляющими общего вектора состояния нейросети, который запоминается при обучении. При экзамене выходы нейронов, определенных как рецепторы, устанавливаются в состояние, соответствующее внешнему стимулу, тогда как выходы остальных нейронов не фиксируются. Обычно такое начальное состояние неустойчиво и сеть начинает конвергенцию в ближайший главный атрактор, соответствующий одному из запомненных ранее состояний. По завершении конвергенции состояния нейронов, которые определены как эффекторы, приобретают значения реакции на заданный стимул.

Хопфилд использовал функцию энергии как инструмент для построения рекуррентных сетей и для понимания их динамики. Формализация Хопфилда сделала ясным принцип хранения информации как динамически устойчивых аттракторов и популяризовала использование рекуррентных сетей для ассоциативной памяти и для решения комбинаторных задач оптимизации.

Динамическое изменение состояний сети может быть выполнено по крайней мере двумя способами: синхронно и асинхронно. В первом случае все элементы модифицируются одновременно на каждом временном шаге, во втором - в каждый момент времени выбирается и подвергается обработке один элемент. Этот элемент может выбираться случайно. Главное свойство энергетической функции состоит в том, что в процессе эволюции состояний сети согласно уравнению она уменьшается и достигает локального минимума (аттрактора), в котором она сохраняет постоянную энергию.

Предложенная еще в 1982 г., модель Д.Хопфилда сулила не только радикальное ускорение процесса обучения, но и открывала перспективу для создания новых параллельных вычислительных систем на основе ИНС. Однако вскоре у нее обнаружился ряд недостатков:

1.Модель Хопфилда пригодна лишь для полносвязных сетей, т.е. каждый нейрон должен иметь связи со всеми остальными нейронами сети.

2.Число запомненных состояний (образов) не может превышать 14% от числа нейронов. При приближении к этой границе появляются ложные атракторы, препятствующие конвергенции к запомненным состояниям, а также возможна потеря устойчивости. 3.Ассоциативная память ИНС не позоляет изымать или изменять ранее занесенные данные, что исключает возможность ее использования в динамическом режиме.

Поэтому, несмотря на огромные преимущества в скорости обучения, сеть Хопфилда так и не нашла применения в прикладных разработках. Среди нашедших заметное практическое применение неитеративных нейропрадигм наиболее известна двусторонняя ассоциативная память (ДАП), представляющая собой двухслойную модификацию сети Хопфилда, в которой процесс конвергенции сокращен до одной итерации.

Несколько менее известна модель ассоциативно-проективной сети, разработанная Э.Куссулем в Институте кибернетики НАН Украины. В этой модели вес связей может принимать лишь значения +1 или 0, благодаря чему достигается чрезвычайно эффективная аппаратная реализация, позволяющая создавать очень большие ИНС (десятки тысяч нейронов). Однако, как и в случае ДАП, избежать недостатков, присущих сети Хопфилда, не удается и в этой модели.

Спиновое стекло - вещество, у которого направления магнитных моментов различных атомов(определяемые спином электронов) беспорядочны, но всегда фиксированы.

Линейно разделимый класс - класс входных стимулов, у которого область значений рецепторов, продуцирующих превышение порогового значения постсиноптического потенциала, отделяется обобщенной плоскостью ( в случае 2 рецепторов - прямой линией).

Ассоциативная память

Если хранимые в сети образцы являются аттракторами, она может использоваться как ассоциативная память. Любой пример, находящийся в области притяжения хранимого образца, может быть использован как указатель для его восстановления.

Ассоциативная память обычно работает в двух режимах: хранения и восстановления. В режиме хранения веса связей в сети определяются так, чтобы аттракторы запомнили набор p n-мерных образцов {x1, x2,..., xp), которые должны быть сохранены. Во втором режиме входной пример используется как начальное состояние сети, и далее сеть эволюционирует согласно своей динамике. Выходной образец устанавливается, когда сеть достигает равновесия.

Сколько примеров могут быть сохранены в сети с n бинарными элементами? Другими словами, какова емкость памяти сети? Она конечна, так как сеть с n бинарными элементами имеет максимально 2n различных состояний, и не все из них являются аттракторами. Более того, не все аттракторы могут хранить полезные образцы. Ложные аттракторы могут также хранить образцы, но они отличаются от примеров обучающей выборки. Показано, что максимальное число случайных образцов, которые может хранить сеть Хопфилда, составляет Pmax ( 0.15 n). Когда число сохраняемых образцов p ( 0.15 n, достигается наиболее успешный вызов данных из памяти. Если запоминаемые образцы представлены ортогональными векторами (в отличие от случайных), то количество сохраненных в памяти образцов будет увеличиваться. Число ложных аттракторов возрастает, когда p достигает емкости сети. Несколько правил обучения предложено для увеличения емкости памяти сети Хопфилда. Заметим, что в сети для хранения p n-битных примеров требуется реализовать 2n связей.

Минимизация энергии

Сеть Хопфилда эволюционирует в направлении уменьшения своей энергии. Это позволяет решать комбинаторные задачи оптимизации, если они могут быть сформулированы как задачи минимизации энергии. В частности, подобным способом может быть сформулирована задача коммивояжера.

Тема 4. Многослойные ИНС.

Первые нейросистемы

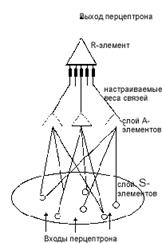

Рис. 6 Перцептрон Розенблатта

Идея построения автомата на основе пороговых элементов, подобных нервным клеткам, способного выполнять логические функции, была высказана более полувека назад Мак-Каллоком и Питтсом. Однако задача проектирования систем на основе пороговых элементов оказалась чрезвычайно трудной, и ее решение, найденное лишь спустя 20 лет, оказалось настолько сложным, что практически исключало возможность синтеза автоматов, содержащих более десятка нейронов. Поэтому уже первые попытки практической реализации таких автоматов были связаны с поиском методов их обучения по аналогии с нервной системой живых организмов.

Обучаемые системы на основе пороговых элементов получили название искусственных нейронных сетей (ИНС). Первые работоспособные ИНС были созданы уже в конце 50-х годов

- перцептрон Ф.Розенблатта,

- "Адалин" В.Уидроу

- и система "Альфа" А.Г.Ивахненко.

К концу 60-х в США действовало несколько экспериментальных моделей ИНС. Первые крупные перцептроны на основе аналоговой и цифровой техники ("Адам-А" и "Адам-Д") за пределами США были созданы в 1969-71 гг. нами в одном из киевских НИИ.

Схема простейшего перцептрона Розенблатта изображена на рис.6. Он содержит три слоя пороговых элементов. Входные сигналы (стимулы), воздействуя на рецепторы (S-элементы), переводят их в возбужденное состояние. S-элементы случайным образом связаны с совокупностью ассоциативных нейронов (А-элементов). Выход А-элемента отличается от нуля только тогда, когда возбуждено достаточно большое число связанных с ним рецепторов. Реакции А-элементов поступают на входы эффекторов (R-элементов) через связи, вес которых изменяется при обучении. В эффекторах вычисляется постсинаптический потенциал - взвешенная сумма поступивших сигналов. Обычно в перцептроне для каждого запоминаемого образа выделяется один эффектор, и решение принимается по максимуму значения постсинаптического потенциала.

Свойственная перцептрону Розенблатта неоднородность структуры (разделение на S-, A- и R-элементы) в более позднихмоделях ИНС утрачивается.

Стандартизуется и модель искусственного нейрона. Нейрон имеет множество входов (синапсов) и единственный выход (аксон), разветвления которого достигают синапсов других нейронов. Выход нейрона принимает значение +1, если постсинаптический потенциал превышает заданный извне порог, или -1 - в противоположном случае. В некоторых моделях ИНС допускаются аналоговые значения выхода в диапазоне (+1,-1) или (+1,0).Такие нейроны действуют как линейные элементы при малых значениях постсинаптического потенциала и как пороговые - при больших.

Рис.7. Многослойная нейронная сеть

Большинство современных ИНС имеют многослойную структуру, изображенную на рис.7. Слой рецепторов воспринимает внешние стимулы (например, элементы изображения), а слой эффекторных нейронов образует выход сети. Между этимислоями располагаются скрытые слои нейронов, не имеющих прямой связи с внешним миром. Нейроны соседних слоев соединены проекционными связями, передающими возбуждение в направлении от рецепторов к эффекторам. Наряду с такими восходящими (афферентными) связями в некоторых моделях могут присутствовать возвратные (эфферентные) связи, действующие в обратном направлении, а также горизонтальные (латеральные), соединяющие нейроны одного слоя.

Нейропарадигмы

Поведение ИНС определяется структурой межнейронных связей, весами синаптических входов и величиной порогов нейронов. Даже в небольших сетях, содержащих несколько десятков нейронов, учесть взаимное влияние этих факторов практически невозможно. Поэтому начиная с перцептрона основное внимание создателей ИНС уделялось разработке и совершенствованию методов их обучения. Из-за отсутствия надежной теории обучения эти разработки носили в основном эвристический характер и получили название нейропарадигм. В табл. 3 приведены 10 наиболее известных сегодня нейропарадигм.

Наиболее известные нейропарадигмы Табл.3

| Название нейропарадигмы | Авторы | Год разработки | Основные области применения |

| Адалин, Мадалин | B. Widrow | 1960 | Адаптивные модемы и эквалайзеры в телефонии |

| Метод адаптивного резонанса | G. Carpenter, S. Grossberg | 1968 | Распознавание образов, особенно если они непривычны для человека (сигналы радара, сонара) |

| Обратного распространения ошибки (back propagation) | P. Werbos, D. Parker, D. Rumelhardt | 1974 | Синтез речи, адаптивный контроль движения роботов, оценка эфективности капиталовложений |

| Неокогнитрон | K. Fucushima | 1978 | Распознавание рукописного текста, иероглифов |

| Карта Кохонена | T. Kohonen | 1980 | Проектирование одной области на другую |

| Сеть Хопфилда | J. Hopfield | 1982 | Поиск и восстановление данных по их фрагментам |

| Двусторонняя ассоциативная память | B. Kosko | 1985 | Контекстно-адресованная асcоциативная память |

| Машина Больцмана | J. Hinton, T. Sejnovsky, H. Szu | 1985 | Распознавание изображений, сигналов радара, сонара |

| Встречного распространения | R. Hecht-Nielsen | 1986 | Сжатие данных, оценка эфективности капиталовложений |

Не останавливаясь на рассмотрении отдельных нейропарадигм (многие из них описаны в книге Ф.Уоссермена), отметим, что их можно разделить на два типа:

-итеративные, следующие правилам модификации веса синапсов, которые предложены в конце 50-х годов биологом Хеббом .

-неитеративные, исходящие из аналогии между нейронной сетью и спиновым стеклом - физической моделью мультистабильной системы (что это такое - будет объяснено чуть ниже).

Итеративные парадигмы

Подавляющее большинство нейропарадигм относится к первому типу. Процесс обучения состоит в коррекции веса межнейронных связей поочередно для каждой запоминаемой пары стимул-реакция. Период, в течение которого выполняются коррекции для всего множества пар, называют эпохой. Процесс обучения может занимать от нескольких десятков до многих тысяч эпох. Перед началом обучения синаптические веса имеют некоторые случайные значения. При вводе запоминаемого стимула появляется определенная реакция нейронов рецепторного слоя. Когда образующаяся волна возбуждения достигает эффекторов, находят величину ошибки - разности между полученным и желаемым значением реакции нейросети. Значение ошибки используется для корректировки веса связей, которая состоит в небольшом (обычно менее 1%) увеличении синаптического веса тех связей, которые усиливают правильные реакции, и уменьшении тех, что способствуют ошибочным.

Данное правило оказывается достаточно эффективным для простейших нейросетей, не содержащих скрытых нейронов (элементарный перцептрон, Адалин). Однако такие нейросети способны распознавать лишь узкий класс линейно разделимых стимулов.

Для решения задач, требующих более сложных правил распознавания, используются ИНС со скрытыми слоями нейронов. В процессе обучения скрытые слои приобретают функции обобщенной модели запоминаемых данных. При формировании такой модели крайне важно избежать ошибок в оценке реакции скрытых нейронов на внешние стимулы и обеспечить правильное направление коррекции веса связей. Сложность этой задачи была осознана еще Розенблаттом, однако ему не удалось найти приемлемого решения. Наиболее совершенное из предложенных решений принадлежит авторам нейропарадигмы обратного распространения ошибки (back propagation - BP). Они нашли и математически обосновали процедуру обучения, которая при достаточном числе итераций коррекции веса гарантирует достижение необходимой точности реакции сети.

В нейропарадигме BP оценка реакции скрытых нейронов производится путем вычисления взвешенного значения ошибки, найденной для слоя эффекторов. В качестве весовой функции используются текущие значения веса проекционных связей, ведущих от скрытых нейронов к эффекторам. Ошибка как бы распространяется в направлении, обратном действующему извне стимулу. Отсюда и происходит название метода. Если скрытых слоев несколько, то подобный пересчет ошибок производят для каждого скрытого слоя начиная от слоя эффекторов.

К сожалению, такой способ оценивания реакций скрытых нейронов не гарантирует правильной коррекции при запоминании каждого следующего стимула. Из-за изменений направления коррекции происходит частичное разрушение накопленной ранее информации. Поэтому для достижения более высокой точности запоминания приходится значительно уменьшать шаг коррекции и многократно повторять итерации, что сильно затягивает процесс обучения.

Для ускорения обучения (сокращения числа эпох) был предложен ряд способов, основанных главным образом на ограничении количества связей, модифицируемых за одну итерацию. Наибольший эффект достигается при организации скрытого слоя в виде сети MAXNET - структуры, в которой в возбужденном состоянии может находиться лишь один нейрон, получивший наибольшее значение постсинаптического потенциала. Этот способ, используемый в нейропарадигмах адаптивного резонанса и встречного распространения, позволяет сократить в 2-5 раз число итераций, однако качество распознавания накопленных данных заметно снижается.

Многослойные сети прямого распространения

Стандартная L-слойная сеть прямого распространения состоит из слоя входных узлов (будем придерживаться утверждения, что он не включается в сеть в качестве самостоятельного слоя), (L-1) скрытых слоев и выходного слоя, соединенных последовательно в прямом направлении и не содержащих связей между элементами внутри слоя и обратных связей между слоями. На рис. 8 приведена структура трехслойной сети.

Рисунок 8.

Типовая архитектура трехслойной сети прямого распространения.

Многослойный перцептрон

Наиболее популярный класс многослойных сетей прямого распространения образуют многослойные перцептроны, в которых каждый вычислительный элемент использует пороговую или сигмоидальную функцию активации. Многослойный перцептрон может формировать сколь угодно сложные границы принятия решения и реализовывать произвольные булевы функции. Разработка алгоритма обратного распространения для определения весов в многослойном перцептроне сделала эти сети наиболее популярными у исследователей и пользователей нейронных сетей. Геометрическая интерпретация объясняет роль элементов скрытых слоев (используется пороговая активационная функция).

RBF-сети

Сети, использующие радиальные базисные функции (RBF-сети), являются частным случаем двухслойной сети прямого распространения. Каждый элемент скрытого слоя использует в качестве активационной функции радиальную базисную функцию типа гауссовой. Радиальная базисная функция (функция ядра) центрируется в точке, которая определяется весовым вектором, связанным с нейроном. Как позиция, так и ширина функции ядра должны быть обучены по выборочным образцам. Обычно ядер гораздо меньше, чем обучающих примеров. Каждый выходной элемент вычисляет линейную комбинацию этих радиальных базисных функций. С точки зрения задачи аппроксимации скрытые элементы формируют совокупность функций, которые образуют базисную систему для представления входных примеров в построенном на ней пространстве.

Существуют различные алгоритмы обучения RBF-сетей. Основной алгоритм использует двушаговую стратегию обучения , или смешанное обучение.

Он оценивает позицию и ширину ядра с использованием алгоритма кластеризации "без учителя", а затем алгоритм минимизации среднеквадратической ошибки "с учителем" для определения весов связей между скрытым и выходным слоями. Поскольку выходные элементы линейны, применяется неитерационный алгоритм. После получения этого начального приближения используется градиентный спуск для уточнения параметров сети.

Этот смешанный алгоритм обучения RBF-сети сходится гораздо быстрее, чем алгоритм обратного распространения для обучения многослойных перцептронов. Однако RBF-сеть часто содержит слишком большое число скрытых элементов. Это влечет более медленное функционирование RBF-сети, чем многослойного перцептрона. Эффективность (ошибка в зависимости от размера сети) RBF-сети и многослойного перцептрона зависят от решаемой задачи.

Нерешенные проблемы

Существует множество спорных вопросов при проектировании сетей прямого распространения - например, сколько слоев необходимы для данной задачи, сколько следует выбрать элементов в каждом слое, как сеть будет реагировать на данные, не включенные в обучающую выборку (какова способность сети к обобщению), и какой размер обучающей выборки необходим для достижения "хорошей" способности сети к обобщению.

Хотя многослойные сети прямого распространения широко применяются для классификации и аппроксимации функций, многие параметры еще должны быть определены путем проб и ошибок. Существующие теоретические результаты дают лишь слабые ориентиры для выбора этих параметров в практических приложениях.

Модель сети с обратным распространением

Способом обратного распространения (back propogation) называется способ обучения многослойных НС. В таких НС связи между собой имеют только соседние слои, при этом каждый нейрон предыдущего слоя связан со всеми нейронами последующего слоя Нейроны обычно имеют сигмоидальную функцию возбуждения. Первый слой нейронов называется входным и содержит число нейронов соответствующее распознаваемому образу. Последний слой нейронов называется выходным и содержит столько нейронов, сколько классов образов распознается. Между входным и выходным слоями располагается один или более скрытых (теневых) слоев. Определение числа скрытых слоев и числа нейронов в каждом слое для конкретной задачи является неформальной задачей.

Принцип обучения такой нейронной сети базируется на вычислении отклонений значений сигналов на выходных процессорных элементах от эталонных и обратном "прогоне" этих отклонений до породивших их элементов с целью коррекции ошибки. Еще в 1974 году Поль Дж. Вербос изобрел значительно более эффективную процедуру для вычисления величины, называемой производной ошибки по весу, когда работал над своей докторской диссертацией в Гарвардском университете. Процедура, известная теперь как алгоритм обратного распространения, стала одним из наиболее важных инструментов в обучении нейронных сетей. Однако этому алгоритму свойственны и недостатки, главный из которых - отсутствие сколько-нибудь приемлемых оценок времени обучения. Понимание, что сеть в конце концов обучится, мало утешает, если на это могут уйти годы. Тем не менее, алгоритм обратного распространения имеет широчайшее применение. Например, успех фирмы NEC в распознавании букв, был достигнут именно благодаря алгоритму обратного распространения.

Обучение нейронных сетей

Мы можем научить трехслойную сеть решать определенную задачу, пользуясь следующей процедурой. Сначала мы предъявляем сети серию тренировочных примеров, которые состоят из паттерна активностей входных элементов вместе с желаемым паттерном активностей выходных элементов.

Предположим, что мы хотим научить сеть распознавать рукописные цифры. Можно воспользоваться матрицей, из 256 сенсоров, каждый из которых регистрирует присутствие или отсутствие чернильного пятнышка в пределах маленькой площадки - фрагмента одной цифры. Для сети, таким образом, потребуется 256 входных элементов (по одному на каждый сенсор), 10 выходных элементов (по одному на каждую возможную цифру) и некоторое количество скрытых элементов.

Для каждой цифры, регистрируемой сенсорами, сеть должна генерировать высокую активность в соответствующем выходном элементе и низкую в остальных выходных элементах.

Чтобы натренировать систему, мы предъявляем ей изображение

цифры и сравниваем действительную активность на 10 выходных элементах с желаемой активностью. Затем мы подсчитываем ошибку, определяемую как квадрат разности между действительным и желаемым выходом. После этого мы изменяем вес каждой связи, с тем чтобы уменьшить ошибку. Описанный процесс тренировки мы повторяем со многими различными написаниями каждой цифры, пока сеть не научится правильно распознавать все возможные изображения.

Чтобы реализовать эту процедуру, нам нужно изменять каждый

вес на величину, пропорциональную скорости, с которой изменяется ошибка по мере изменения веса. Эта величина (называемая производной ошибки по весу и обозначаемая EW) вычисляется не просто.

Один из способов вычисления EW заключается в том, чтобы изменить вес на очень маленькую величину и посмотреть, как изменится ошибка. Однако этот метод не эффективен, поскольку требует отдельных вариаций для каждого из многих весов.

Алгоритм обратного распространения

Идея создания алгоритма обратного распространения

Примерно в 1974 году Поль Дж. Вербос изобрел значительно более эффективную процедуру для вычисления EW, когда работал над своей докторской диссертацией в Гарвардском университете. Процедура, известная теперь как алгоритм обратного распространением (back propagation algorithm), стала одним из наиболее важных инструментов в обучении нейронных сетей.

Алгоритм обратного распространением проще всего понять, когда все элементы сети линейны. Алгоритм вычисляет каждую EW, сначала вычисляя EA - скорость, с которой изменяется ошибка при изменении уровня активности элемента. Для выходных элементов EA является просто разностью между действительным и желаемым выходом.

Чтобы вычислить EA для скрытого элемента в слое, непосредственно предшествующем выходному слою, мы сначала идентифицируем все веса между этим скрытым элементом и выходными элементами, с которыми соединен данный скрытый элемент. Затем мы умножаем эти веса на величины EA для этих выходных элементов и складываем полученные произведения. Эта сумма и равна EA для данного скрытого элемента.

Вычислив EA для всех элементов скрытого слоя, прилегающего к выходному, мы можем аналогичным образом рассчитать EA и для других слоев, перемещаясь в направлении, обратном тому направлению, в котором активность нейронов распространяется по сети. Отсюда и название алгоритма обратного прослеживания (или обратного распространения). После того как значение EA для элемента вычислено, подсчитать EW для каждой входной связи элемента уже несложно. Величина EW является произведением EA и активности во входной цепи.

Для нелинейных элементов алгоритм обратного распространением включает дополнительный шаг перед перемещением в обратном направлении EA необходимо преобразовать в EI - скорость, с которой изменяется ошибка по мере изменения суммарного входа элемента.

Описание НС и алгоритма обратного распространения

Чтобы обучить нейронную сеть решению какой-либо задачи, мы

должны подправлять веса каждого элемента таким образом, чтобы

уменьшалась ошибка - расхождение между действительным и желаемым выходом. Для этого нужно, чтобы нейронная сеть вычисляла производную от ошибки по весам (EW). Другими словами, она должна вычислять, как изменяется ошибка при небольшом увеличении или уменьшении каждого веса. Чаще всего для вычисления EW применяется алгоритм обратного распространением.

Чтобы реализовать этот алгоритм, мы сначала должны дать математическое описание нейронной сети. Предположим, что элемент j - типичный элемент выходного слоя, а элемент i типичный элемент слоя, который предшествует выходному. Активность элемента выходного слоя определяется двухшаговой процедурой. Сначала вычисляется суммарный взвешенный вход Xj с помощью формулы

Xj = S (Yi * Wij), (1)

i

где Yi - уровень активности i-го элемента в предшествующем слое и

Wij - вес связи между i-м и j-м элементами.

Далее, элемент вычисляет активность Yj с помощью некоторой

функции от суммарного взвешенного входа. Обычно применяется сигма-функция:

Yj = 1 / (1 + e^(-Xj)). (2)

После того как активности всех выходных элементов определены, сеть вычисляет ошибку, которая определяется выражением

E = 1/2 * S (Yj - Dj)^2, (3)

j

где Yj - уровень активности j-го элемента в верхнем слое, а Dj -

желаемый выход j-го элемента.

Алгоритм обратного распространением состоит из четырех шагов.

1) Вычислить, насколько быстро меняется ошибка при изменении

выходного элемента. Эта производная ошибки (EA) есть разность

между действительной и ожидаемой активностью.

dE

EAj = ---- = Yj - Dj. (4)

dYj

2) Вычислить, насколько быстро изменяется ошибка по мере изменения суммарного входа, получаемого выходным элементом. Эта величина (EI) есть результат шага 1, умноженный на скорость изменения выходного элемента с изменением его суммарного входа.

dE dE dYj

EIj = = --- * --- = EIj Yj (1 - Yj). (5)

dXj dYj dXj

3) Вычислить, как быстро изменяется ошибка по мере изменения

веса на входной связи выходного элемента. Эта величина (EW) есть

результат шага 2, умноженный на уровень активности элемента, из которого исходит связь.

dE dE dXj

EWij = ---- = --- * --- = EIj Yi. (6)

dWij dXj dXij

4) Вычислить, как быстро изменяется ошибка с изменением активности элемента из предыдущего слоя. Этот ключевой шаг позволяет применять обратное распространение к многослойным сетям. Когда активность элемента из предыдущего слоя изменяется, это влияет на активности всех выходных элементов, с которыми он связан. Поэтому, чтобы подсчитать суммарное воздействие на ошибку, мы складываем все эти воздействия на выходные элементы. Но эти воздействия нетрудно подсчитать. Этот результат шага 2, умноженный на вес связи к соответствующему выходному элементу.

dE dE dXj

EAi = ---- = S (--- * --- ) = S (EIj Wij). (7)

dYi j dXj dYij j

Пользуясь шагами 2 и 4, мы можем преобразовать величины EA

одного слоя элементов в EA предыдущего слоя. Эту процедуру можно повторять, чтобы вычислять EA стольких предыдущих слоев, сколько их есть. Зная EA для элемента, мы можем воспользоваться шагами 2 и 3, чтобы вычислить EW на его выходных связях.

Современная оценка алгоритма обратного распространения

На протяжении нескольких лет после его изобретения алгоритм обратного распространением оставался почти незамеченным, вероятно, потому, что не был в должной мере оценен специалистами. В начале 80-х годов Д. Румельхарт, работавший в то время в Калифорнийском университете в Сан-Диего, и Д. Паркер из Станфордского университете независимо друг от друга вновь открыли алгоритм. В 1986 году Румельхарт, Р. Уильямс, также из Калифорнийского университета в Сан-Диего, и Джеффери Е. Хинтон продемонстрировали способность алгоритма обучить скрытые элементы вырабатывать интересные представления для сложных паттернов на входе и тем самым сделали его известным.

Алгоритм обратного распространения оказался на удивление эффективным в обучении сетей со многими слоями решению широкого класса задач. Но более всего он эффективен в ситуациях, когда отношении между входом и выходом нелинейны, а количество обучающих данных велико. Применяя алгоритм, исследователи создали нейронные сети, способные распознавать рукописные цифры, предсказывать изменения валютного курса и оптимизировать химические процессы. Они даже воспользовались алгоритмом для обучения сетей, которые идентифицируют переродившиеся предраковые клетки в анализируемых образцах ткани и регулируют положение зеркал в телескопах, чтобы исключить атмосферные искажения.

Р. Андерсен из Массачусетского технологического института и

Д. Зипсер из Калифорнийского университета в Сан-Диего показали,

что алгоритм обратного распространения представляет собой весьма эффективный инструмент для понимания функций некоторых нейронов в коре головного мозга. Они научили нейронную сеть реагировать на зрительные стимулы, применив алгоритм обратного распространения.

Затем они обнаружили, что реакция скрытых элементов удивительно схожа с реакцией реальных нейронов, выполняющих преобразование зрительной информации, поступающей от сетчатки, в форму, необходимую для более глубоких областей мозга, перерабатывающих зрительную информацию.

Метод обратного распространения достаточно хорош при создании представлений о распознаваемом образе в скрытых элементах сети. Алгоритм обратного распространения показал эффективность процедур обучения НС, в которых веса постепенно изменяются, чтобы уменьшить ошибки. Раньше многие ученые полагали, что подобные методы окажутся безнадежными, поскольку должны неизбежно приводить к локально оптимальным, но в более широком масштабе ужасным решениям. Например, сеть для распознавания цифр может устойчиво сходиться к набору весов, при котором она будет путать единицы с семерками, хотя существует набор весов, позволяющий различать эти цифры наряду с другими. Из-за опасений подобного рода распространилось убеждение, что процедура обучения представляет интерес только в том случае, если она гарантирует сходимость к глобально оптимальному решению. Метод обратного распространения показал, что для многих задач глобальная сходимость не является необходимым условием для того, чтобы достичь хороших результатов.

С другой стороны, с биологической точки зрения, как подобие

работы головного мозга, метод обратного распространения выглядит не очень убедительным. Наиболее очевидная трудность заключается в том, что информация должна проходить по тем же самым связям в обратном направлении, от каждого последующего уровня к предыдущему.

Ясно, что этого не происходит в реальных нейронах. Однако этот

довод на самом деле является довольно поверхностным. В мозге существует множество путей, ведущих от следующих слоев нервных клеток к предыдущим, и эти пути могут использоваться многообразными способами для передачи информации, необходимой для обучения.

Более серьезную проблему представляет собой быстродействие

алгоритма обратного распространения. Здесь центральным является вопрос о том, как быстро растет время, необходимое для обучения, по мере возрастания размеров сети. Время, требующееся для вычисления производных от ошибки по весам на заданном тренировочном примере, пропорционально размерам сети, поскольку объем вычислений пропорционален количеству весов. Однако более крупные сети требуют большего количества тренировочных примеров, и им приходится модифицировать веса большее число раз. Следовательно, время обучения растет значительно быстрее, чем размеры сети.

Самая серьезная проблема метода обратного распространения

заключается в том, что такая НС требует учителя, предоставляющего желаемый выход для каждого тренировочного примера. В отличие от этого человек обучается большинству вещей без помощи учителя.

Никто не дает нам детального описания внутренних представлений

мира, которые мы должны научиться извлекать из нашего сенсорного входа. Мы учимся понимать речь или зрительные сцены без каких-либо прямых инструкций.

Если сеть сталкивается с большим набором сочетаний сигналов,

но не имеет никакой информации о том, что с ними следует делать,

то, очевидно, перед ней нет четко поставленной задачи. Тем не менее исследователи разработали несколько универсальных, неконтролируемых процедур, которые могут правильно регулировать весовые параметры сети. Все эти процедуры имеют два общих качества: они оперируют, явно или неявно, с некоторым понятием качества представления и работают, изменяя веса, чтобы повысить качество представления, вырабатываемого скрытыми элементами. Не смотря на отмеченные недостатки применение метода обратного распространения в целях прогнозирования требований оправданно, так как при прогнозировании не возникает ситуации неопределенности действий, которые необходимо проделать с информацией поступающей на вход НС.

Тема 5. Специализированные ИНС.

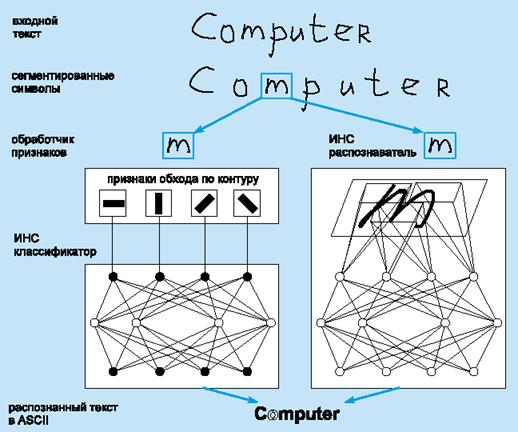

Следует иметь в виду, что для успешного решения реальных задач необходимо определить ряд характеристик, включая модель сети, ее размер, функцию активации, параметры обучения и набор обучающих примеров. Для иллюстрации практического применения сетей прямого распространения рассмотрим проблему распознавания изображений символов (задача OCR, которая состоит в обработке отсканированного изображения текста и его преобразовании в текстовую форму).

Система OCR